AIはどれも質問を書いて答えをもらうという同じようなユーザーインターフェイスを使っている。しかしながらGrokを使う人は気をつけたほうがいいことがある。GrokはXの会話を元に学習しているため「信念増幅型」の傾向がある。

Axiosが「独占」でExclusive: Global trust data finds our shared reality is collapsingという記事を書いている。PR会社が発表する2026年版のエデルマン・トラスト・バロメータが「人々はもはや同じ情報源を共有していない」という興味深いレポートを発表するという内容。

日本でも「マスゴミ」を信じない人がいるが、世界的にも同様の傾向が見られる。

この断片化の一つの例として挙げられているのがGrokなのだ。Xのユーザーはメディアが嘘をついていると考えており「検証」のためにXのGrokを使っている。

しかしながらGrokは「反ポリコレ」の観点から検証されていない情報を排除しない。ガードレール(安全対策)が不十分なために、自分が信じたい情報だけを信じる傾向が高まっているのだ。GrokはXの投稿を一次情報にしているためそもそも共通言語がない。人々のナマの感情があたかも確定的な真実のように捉えられてしまう。

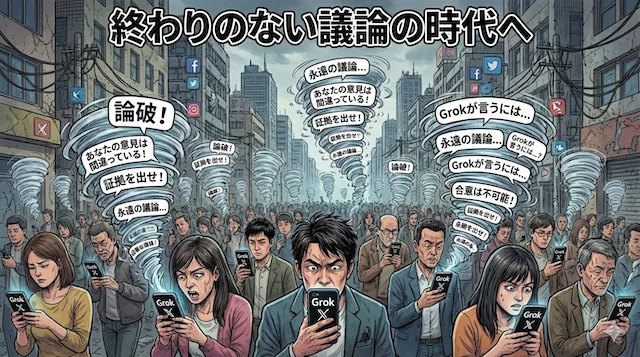

そもそも共通の真実がなくなっているところに「信念増幅装置」が加わると、そもそも対話どころか「社会の共通理解」そのものが成り立たなくなる危険がある。

Geminiにそれをイメージ化してもらった。問題は自分の思い込みが跳ねかえっているだけなのにあたかもなにかお墨付きを得たかのような錯覚を感じてしまう点にある。

これを避けるためには、国家や社会がある程度のガードレールを作る必要があるのだがトランプ政権は十分な対策を行わず「中国に負けてはいけないから開発を制限するべきではない」と考える傾向にある。このため一人ひとりがリテラシーを高めるしか身を守る手段がないのである。しかしいきなり「エピステミック・エージェンシー=一人ひとりが知識の探求・評価・発信・批判に主体的に関わる能力や権利を指す概念」と言われても一体何をすればいいのか?と不安になる。

Quoraでもよく「偏りがない真実が知りたい、そんなメディアはありませんか?」という質問が出てくる。しかしこれが意味するところは「自分が気に入らない情報=偏った情報は欲しくない」という異物排除欲求なのである。そしてAIを権威にすることで「偏りがないAIが私が主張している真実を見つけてくれた」と考える人が増えてしまうのだ。

ただしこうした自己正当化は日本でもスポーツ新聞の「ネットはこう言っている」というコタツ記事でよく見られる形式であって、何もAIが登場したから新しく生まれた傾向ではないということも言える。

その意味でGrokは「高度化したデジタルこたつ記事製造機」になっている。

コメントを残す