Quoraに「AIは毎回言うことが違う」という質問が出ていた。そのような経験をしたことがないためChatGPTになぜそうなるのかを聞いてみた。

まず、ChatGPTの言うことがすぐに変わると感じる人と感じない人ははっきり別れる傾向があるという。

意見が変わる感じる人には次のような特徴があるそうだ。

- 目的・評価軸が曖昧

- 文脈が省略されている

- 質問者側が「判断を委ねている」

- 会話を人格的に解釈している

まずプロンプトの中に「判断基準」がない場合、ChatGPTはその場でもっともらしいと思われる答えを生成する。このためちょっとした文章の違いで結果が大きく変わってしまう。また雑談などでも「その時々でランダムな答え」が出てくる。

このChatGPTには日本人ならではの特徴が書かれていない。日本人が他人に意見を求める場合、実はそれは承認を求めている場合が多い。つまり前に出てきた出力を基に「ChatGPTはこういう人格なのだろう」とあらかじめ想定し、自分の質問に対して自分が望むような結果が出ることを期待しているのである。

しかしながらChatGPTは論理回路なのでそもそも人格が存在しない。ないものを見てもコントロールはできないのでそのたびごとにズレていると感じる。その正体は「自分の期待通りの反応が出ない」といういらだちだ。

これを無自覚に自己判断を外注していると言っているが、そもそも自己判断を外注する傾向が強い日本人にはなかなか理解が難しいコンセプトだろう。

現在のAIは「推論」が難しく、相手の欲求を忖度して望ましい答えを返してくれるところまでの性能はない。しかしながらChatGPTはメモリを持っており、蓄積したトピックに対するポジションとユーザー理解を保持している。つまり、継続して一つの論を組み立てるのにはChatGPTは使いやすいという印象がある。

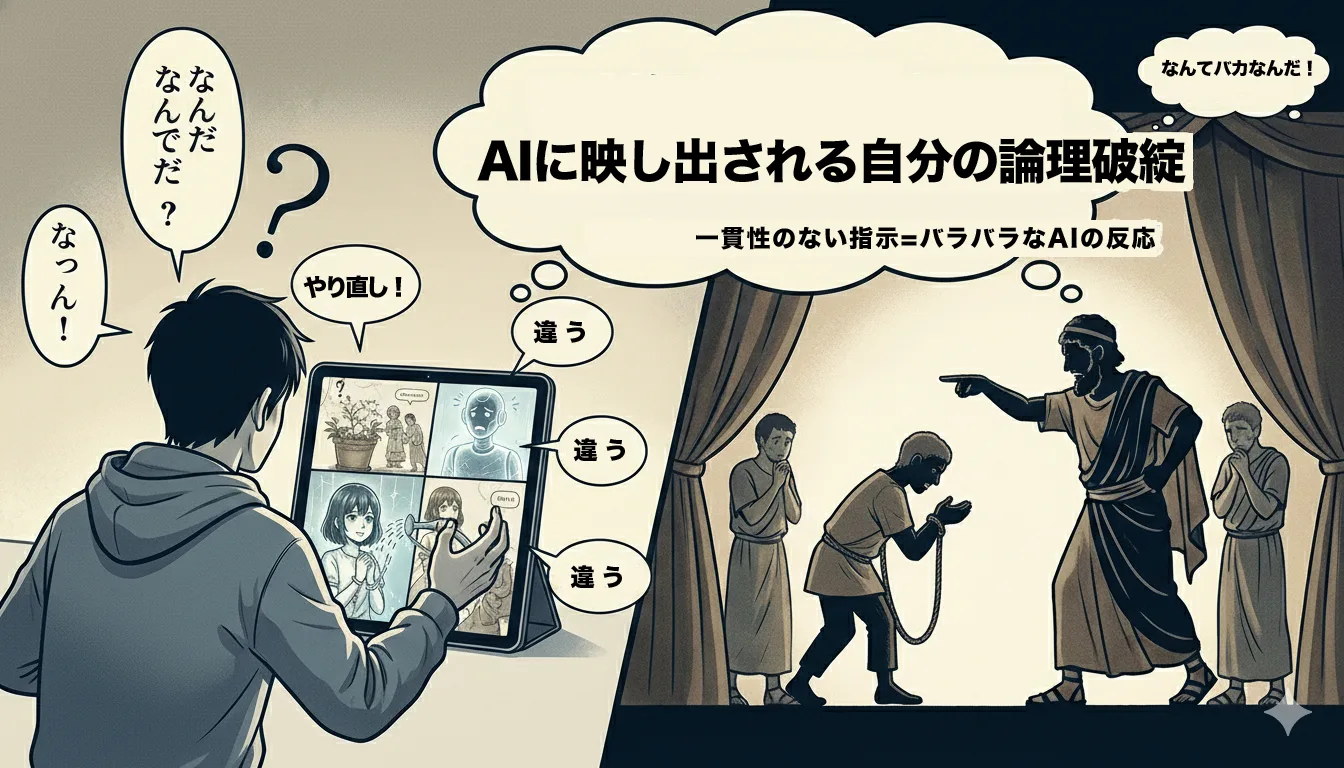

このことから「AIはそのたびごとに違った出力する」と言っている人たちは、実は自分の聞き方が一貫していないと告白していることになる。これが相談であればよいのだが、いっけん論理的な質問をしているのに一貫した答えを得られていないという人は、実はその人の内部ロジックが破綻しているか一貫していないと告白していることになってしまうのである。

コメントを残す